[Machine Learning] 인공지능이란?

인공지능 ⊃ 머신러닝 ⊃ 인공신경망 ⊃ 딥러닝

인공지능 : 인간이 가진 지적 능력을 컴퓨터를 통해 구현하는 기술

머신러닝 : 알고리즘을 이용해서 컴퓨터가 데이터로부터 스스로 학습해서 판단이나 예측을 수행하는 인공지능의 성능을 향상시키는 방법

딥러닝 : 인공신경망을 기반으로 복잡하고 비선형적인 문제를 스스로 학습해서 문제해결하는 기술

>> 이러한 알고리즘은 사물 분류, 패턴 발견, 결과 예측, 정보 기반 의사결정 등을 수행하도록 설계됨

머신러닝 학습 종류

- 지도학습(Supervised Learning) : 특징(Feature)와 정답(Label)을 학습시킴(정답이 있는 데이터 활용&학습)

> 회귀(예측), 분류

- 비지도학습(Unsupervised Learning) : 정답이 없이 데이터의 특징(입력데이터)만 학습, 데이터간의 관계를 찾는 학습방법

> 군집(Clustering), 연관, 차원축소

- 강화학습 : 학습하는 시스템이 행동을 실행하고 그 결과에 따른 보상이나 벌점(숫자)을 받는 방식으로 학습

> 알파고, 고위험 주식 시장 등

- 준지도학습 : 한 쪽의 소량 데이터에 있는 추가 정보를 활용해 다른 대용량 데이터 학습에서의 성능을 높이는 것을 목표

> ‘데이터 labeling’ 작업에 소요되는 많은 자원과 비용 때문에 등장

| 지도학습 (Supervised Learning) |

Classificaion(분류) : 범주형 분류 : 질적 : 평가측도(MSE, MAE, MAPE, RASE..) |

- kNN - Naive Bayes - Support Vector - Logistic Regression - Decision Tree - Random Forest - Neural Network |

| Regression(회귀) : 연속형 수치 예측 : 양적 : 평가측도(오분류율, 특이도, 민감도...) |

- Linear Regression - Locally Weighted Linear - Ridge - Lasso |

|

| 비지도학습 (Unsupervised Learning) |

- Clustering - K-Means - Density Estimation - Exception Maximization - Pazen Window - DBSCAN |

- 그룹화(grouping) : 군집분석, 연관성분석 계열

- 차원축소(dimensionmality reduction) : 변수선택, 변수 결합

- 예측 주목적 : 해석이 난해한 모형도 후보 모형 (인공신경망, 랜덤 포레스트, SVM, 딥러닝 모형 등) => 블랙박스 모형

- 추론 주목적 : 해석이 쉽고 직관적인 모형, 관계파악이 주목적 (의사결정나무, 회귀모형 등) => 화이트박스 모형

변수 간 관계

- 독립관계(영향x)

- 상관관계(한 변수가 변하면 다른 한 변수도 변화)

- 인과관계(한 변수가 다른 변수의 변화에 원인 되는 관계): 성립조건 - 시간우선성, 공변성, 외생변수통제

- 쌍방항적 인과관계(원인과 결과과 동시에 될 수 있음 > 인과성이 쌍방으로 미침)

- 조정관계(독립변수가 종속변수에 미치는 영향력이 독립변수2(조절변수)에 따라 다른 경우

- 매개관계(독립변수의 결과면서 동시에 종속변수의 원인이 되는 변수의 관계)

- 참고: https://m.blog.naver.com/ad_factory/110187577997

딥러닝 동작원리

- 단층 퍼셉트론(single layer perceptron)

> 각 노드의 입력치*가중치의 합과 활성화 함수가 가지고 있는 임계치와 비교

- 다층 퍼셉트론(MultiLayer Perceptron, MLP)

: 비선형 문제까지도 해결 가능

: 심층 신경망 (Deep Neural Networks)으로 불림

: 수동으로 특징을 추출하지 않고 데이터에서 직접 기능을 학습하는 신경망 아키텍처와 함께 레이블링된 대단위 데이터를 활용하여 훈련

단층 퍼셉트론들의 조합으로 신경망은 상호 연결된 노드의 집합으로 구성되어 있는 레이어로 이뤄짐

딥 신경망 유형

- CNN(Convolutional Neural Networks) ConvNet

: 이미지에서 직접 특징을 추출하여 작동

: 사전 훈련되지 않으며 네트워크가 이미지 모음에서 훈련하는 동시에 학습

: 수십 개 또는 수백 개의 숨겨진 레이어를 사용하여 이미지의 다른 특징을 감지하는 방법을 학습

: 숨겨진 모든 레이어는 학습된 이미지 특징의 복잡도를 증대합니다.

- 순환신경망(RNN. Recurrent Neural Network)

: 순차적 정보가 담긴 데이터에서 규칙적인 패턴을 인식하고, 추상화된 정보를 추출

: 텍스트, 음성, 음악, 영상 등 순차적 데이터를 다루는 데 적합

: 그레디언트 소실 문제(Gradient Vanishing Problem)가 있어 패턴 학습을 못하는 경우를 개선하기 위해, LSTM(Long Short Term Memory)가 개발됨

: 자동 작곡, 작사, 저술, 주가 예측 등 다양한 분야에 활용

- 볼츠만 머신(RBM. Restricted Boltzmann Machine)

: 확률밀도함수(probability density function, pdf)를 모델링하는 Generative Model

: 목적 = 확률분포를 정확히 학습해 좋은 sample을 sampling하는 것

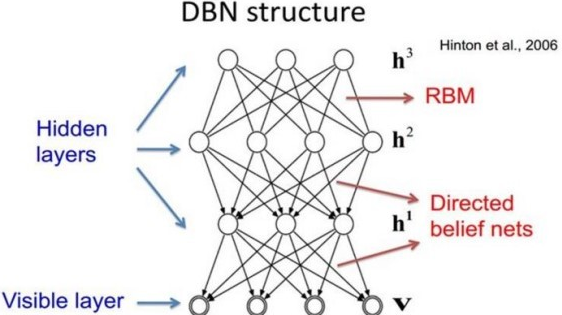

- 심층 신뢰 신경망(DBN. Deep Belief Network)

: 잠재 변수(latent variabl)의 다중 계층으로 이뤄진 신경망

: 사전 훈련된 RBM을 층층이 쌓아 올린 구조

: 라벨이 없는 데이터에 대한 비지도학습 가능

: 부분적인 이미지에서 전체를 연상하는 일반화, 추상화 과정을 구현 가능

- GAN(Generative Adversarial Network. 생성 대립 신경망)

: 비지도 학습 방법

: 훈련으로 학습된 패턴을 이용해, 이미 지나 음성을 생성할 수 있다.

: 이미지 및 음성 복원 등에 적용

* 내용참고&출처 : 태그에서 수강한 수업을 복습 목적으로 정리한 내용입니다.